Der folgende Blog-Beitrag ergänzt den letzten Blog-Beitrag vom Januar 2025: IIT – Die Vermessung des Bewusstseins oder das menschzentrierte Weltbild wackelt.

Bilder erzeugt von ChatGPT/Dall-E auf der Basis der Blog-Beiträge; die Collage stammt von mir!

Im letzten Blog-Beitrag habe ich die IIT, die Integrated Information Theory, auf die Vermessung des Team-Bewusstseins, den Collective Mind, angewendet. Es ergaben sich folgende Aussagen:

Auch wenn wir nicht wissen was Bewusstsein ist, so können wir dieses dennoch vermessen, wenn wir einen entsprechenden Platzhalter finden, der Bewusstsein repräsentiert. Die IIT behauptet, dass dieser Platzhalter die Integrierte Information ist. Die Integrierte Information zeichnet sich im Wesentlichen durch zwei Eigenschaften aus: Die Prozesse, die im Gehirn (oder im Team) ablaufen bilden Kausalketten und eine Aufteilung der Systemstrukturen in Teil-Strukturen führt zu einem substantiellen Verlust an Information.

Die IIT arbeitet mit binären Zuständen eines mehr oder weniger komplexen Netzwerkes: Interpretiert man die emotionalen bzw. mentalen Zustände von Menschen sehr vereinfacht als binäre Zustände und die Kommunikation zwischen Menschen als Interaktion in einem Netzwerk, lässt sich der IIT Algorithmus zur Berechnung von Bewusstsein, gemessen als Phi, auf Teams anwenden.

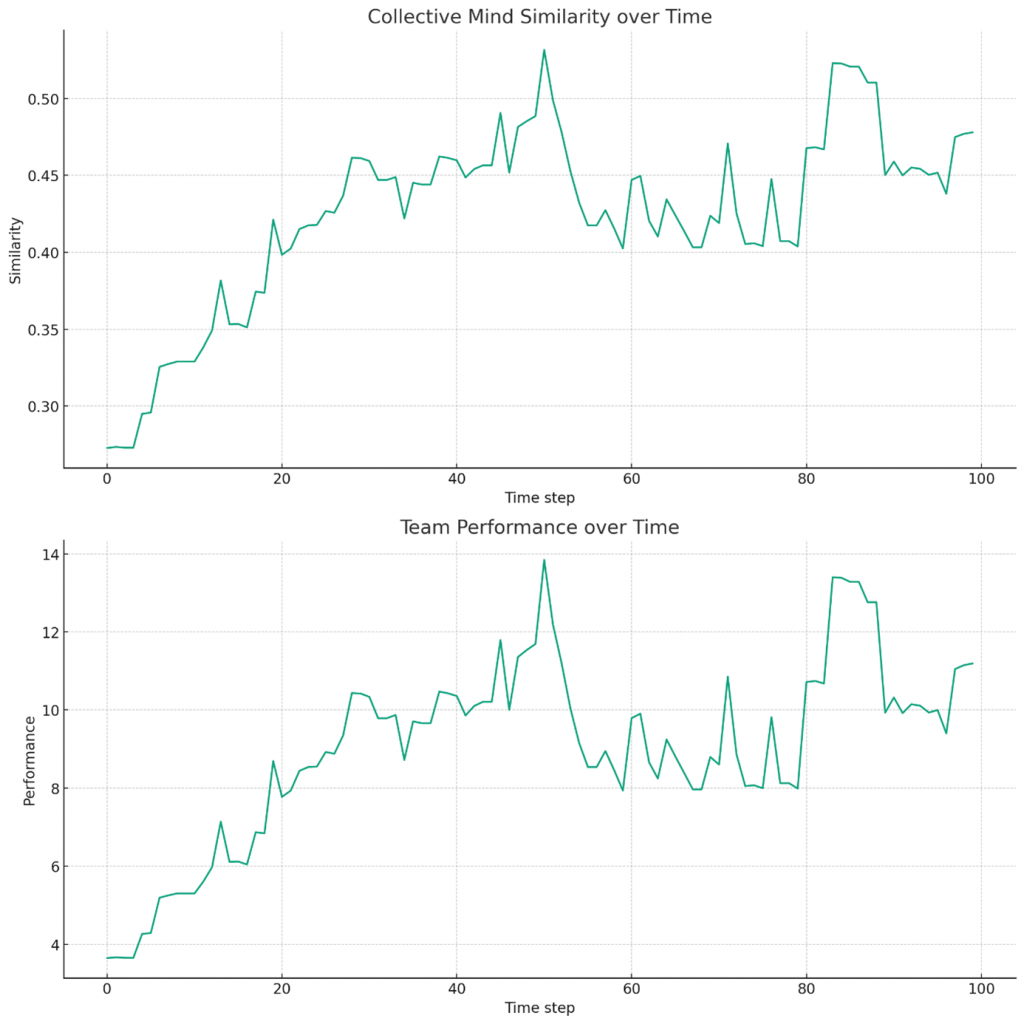

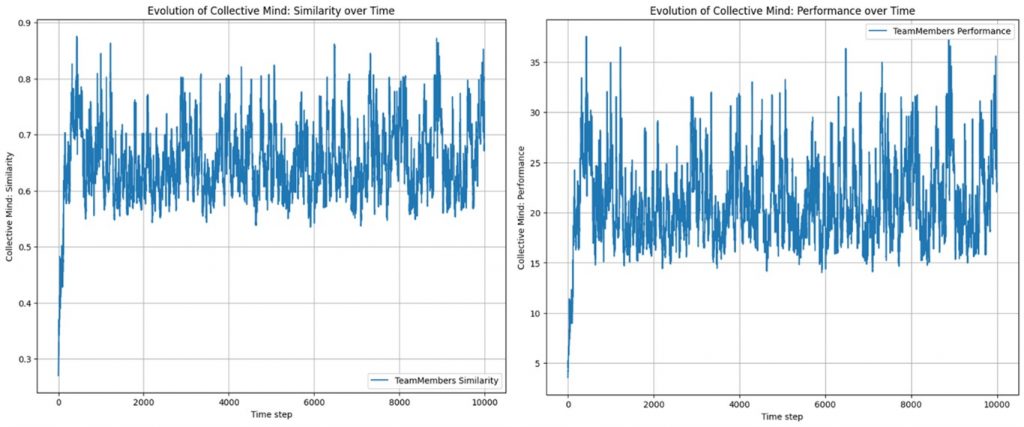

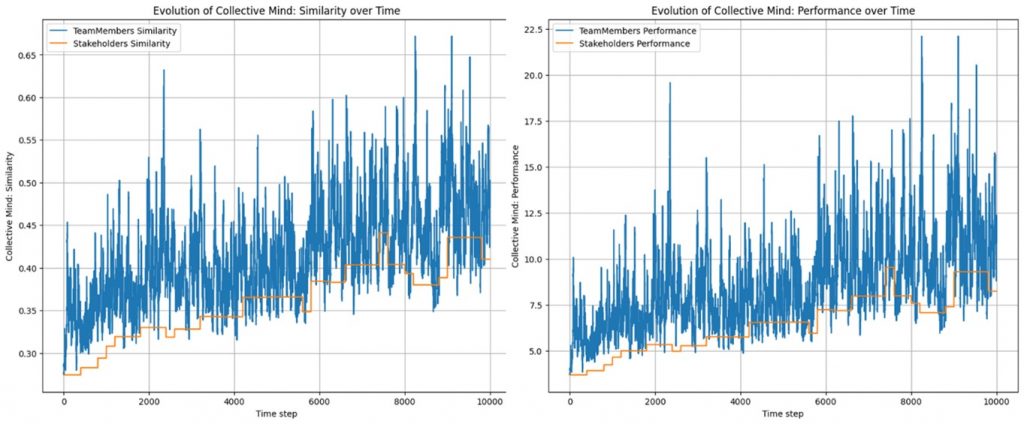

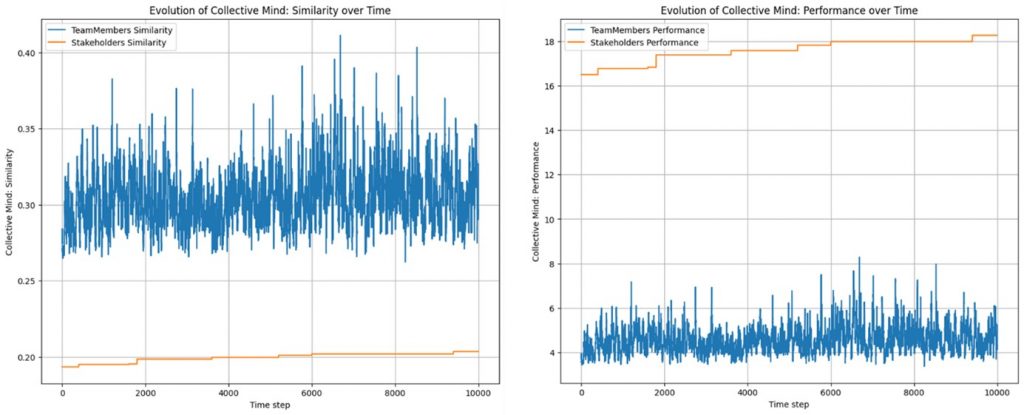

Der Phi-Team Wert unterliegt recht großen Schwankungen, je nach dem auf welchen Team-Zustand man die Berechnung anwendet. Gemäß IIT ist dies ‚verständlich‘, denn beim menschlichen Bewusstsein werden ebenfalls sehr große Bewusstseins-Schwankungen im Schlaf, unter Müdigkeit und bei hoher Konzentration festgestellt.

Es ergaben sich erhebliche Zweifel, ob Phi wirklich Bewusstsein misst oder lediglich die Aussage ‚Das Ganze ist mehr als die Summe seiner Teile‘. Der Inhalt der Prozesse ist für die Stärke von Phi ohne Bedeutung: Für ein Gehirn heißt dies, dass ‚Unsinn‘ gedacht werden kann und doch ein großes Phi vorliegt. – Für ein Team heißt dies, dass ‚Unsinn‘ geredet werden kann, und doch ein großes Phi vorhanden ist.

Es ist mir nicht gelungen, über die Einstellung von Team-Parametern, Phi-Team Werte zu erzeugen, die in ihrer maximalen Größe denjenigen der IIT-Literatur entsprechen. Meine Phi-Team Strukturen sind in den einfachsten Fällen schon um ein Vielfaches umfangreicher als diejenigen der kognitiven IIT-Literatur. Die Anwendung auf realistische Teamstrukturen von zum Beispiel 7 Teammitgliedern mit entsprechend differenzierten Persönlichkeitsstrukturen ist mit meinen Hardware- Ressourcen nicht durchführbar.

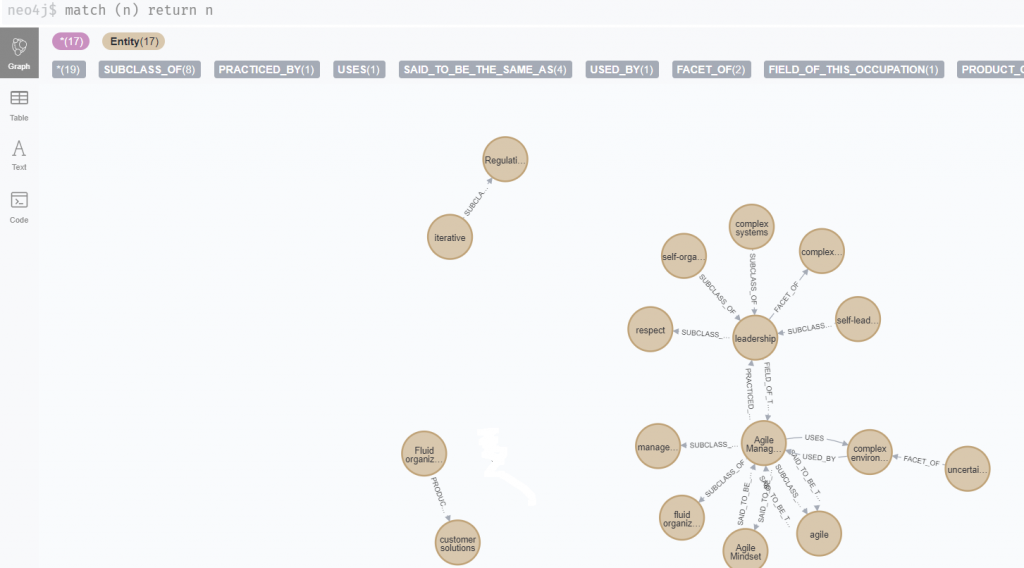

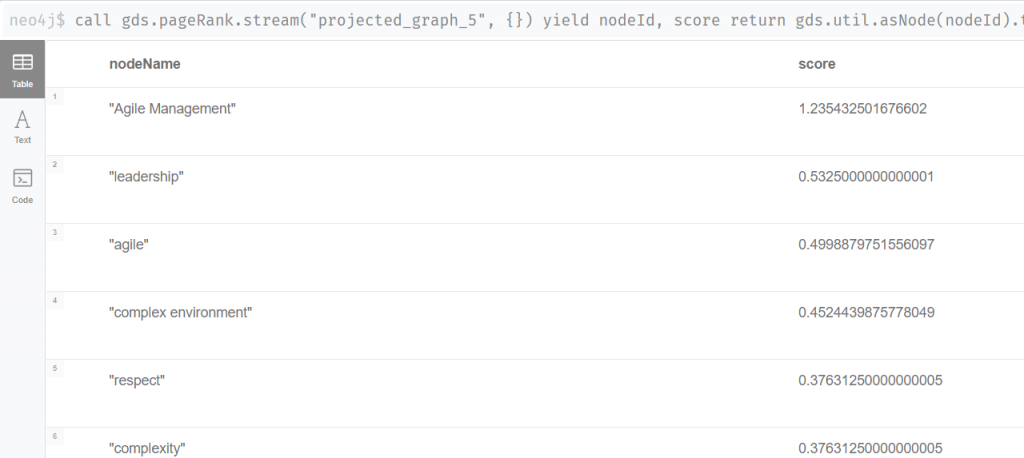

Also kam die Idee auf, einfache Netzwerk-Beispiel aus der IIT-Literatur zu nehmen und hierfür eine Kommunikation zu erstellen. Ich habe ein Netzwerk mit 3 Knoten aus [1] als Beispiel genommen und das auf [2] hierzu verfügbare Demo Jupyter Notebook verwendet.

Um die genauen Mechanismen im Notebook besser zu verstehen, habe ich wieder ChatGPT 4o1 zu Rate gezogen: Es war um den 20.01.2025 als ich feststellte, dass das Reasoning von ChatGPT einen dramatischen Einbruch hatte. – ChatGPT machte wieder häufig Programmierfehler und die korrekte Anwendung von IIT spezifischen Datenstrukturen – hier die sogenannte TPM – Transition Probability Matrix – war einfach nicht möglich. Die TPM Datenstruktur gehört in den Bereich des didaktischen Albtraums, den ich schon im letzten Blog erwähnte. Ich brauchte recht viel Zeit, um die TPM zu verstehen und ChatGPT ist es überhaupt nicht gelungen, die korrekte Datenstruktur, ohne meine Hilfe, aufzusetzen. Also dachte ich, ich versuche es mal bei DeepSeek R1, der Reasoning Variante von DeepSeek, die besonders für wissenschaftliche und programmiertechnische Assistenz gedacht ist: Das Hochladen des IIT Jupyter Notebooks wurde damit beendet, dass mir mitgeteilt wurde, nur 15% des Notebooks könnten berücksichtigt werden. Erste Fragen zur TPM wurden damit quittiert, dass das System mir sagte, es könnte wegen Überlastung keine Antwort geben. Ein paar Tage später versuchte ich es wieder und erhielt zur TPM ähnlich falsche Antworten wie bei ChatGPT. Als ich DeepSeek mitteilte, dass seine Antwort falsch ist, erhielt ich keine Antwort mehr, selbst nach mehrmaligem nachfassen. Die Euphorie zu DeepSeek kann ich also aufgrund dieser Erfahrungen nicht teilen: Zwischen DeepSeek und ChatGPT, selbst in der schlechtesten Variante, liegen meines Erachtens Welten.

Nun zu der Ergänzung für IIT-Team:

Ich habe das einfache Netzwerk aus drei Knoten (A, B, C), also drei Teammitgliedern (Projektleiter, Wissenschaftler, Marketingspezialist) verwendet. Dieses Netzwerk hat ein Phi = 2-5 bits und ist damit mindestens eine Größenordnung ‚bewusster‘ als meine Teams im letzten Blog. Ich habe ChatGPT gebeten auf der Basis der TPM und der sogenannten Connectivity Matrix des Netzwerkes im Jupyter – Notebook eine Team-Kommunikation zu erstellen. Außerdem gab ich vor, dass die Kommunikation zu einem Projekt der Medikamentenherstellung in der Pharmaindustrie gehören soll.

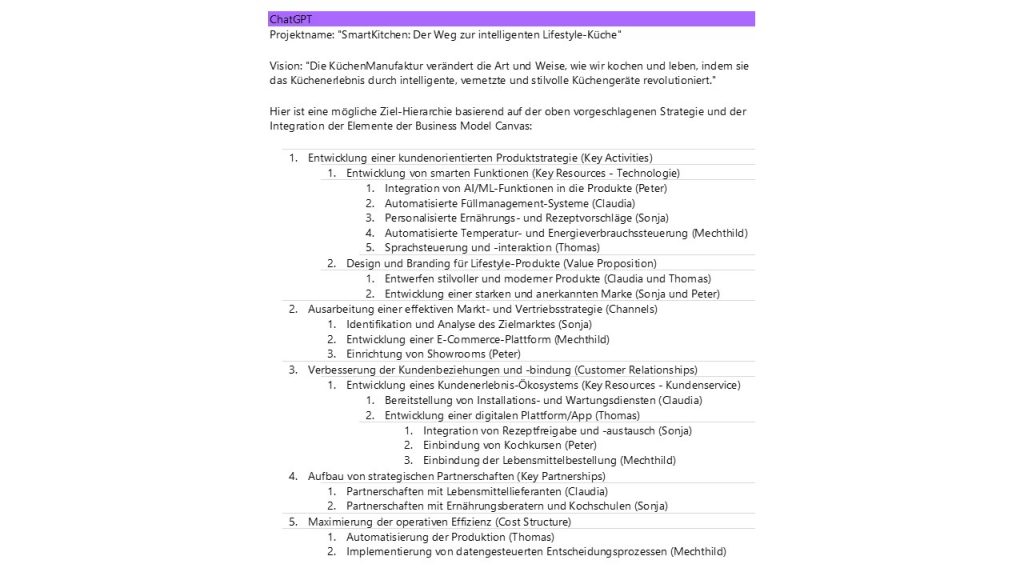

Hier ist das Ergebnis als Output von ChatGPT, im Wesentlichen im Original-Zustand belassen:

📌 Startzustand:

- Projektleiter spricht (1,0,0)

- Wissenschaftler und Marketingspezialist hören zu (0,0)

📌 Schritt 1: Der Projektleiter eröffnet die Diskussion (Zustand: (1,0,0))

Projektleiter (A):

„Unser Ziel ist es, die Stabilitätsprobleme schnell zu lösen. Welche Variablen beeinflussen die Lagerfähigkeit unseres Medikaments am stärksten?“

📌 Laut TPM ist der Übergang zu (1,1,0) wahrscheinlich, da B (Wissenschaftler) aktiviert wird.

🔄 Nächster Zustand: (1,1,0)

- Projektleiter bleibt aktiv (A=1)

- Wissenschaftler wird aktiv (B=1)

- Marketingspezialist bleibt inaktiv (C=0)

📌 Schritt 2: Wissenschaftler bringt erste Analysen ein (Zustand: (1,1,0))

Wissenschaftler (B):

„Die Stabilität hängt stark von der chemischen Zusammensetzung und den Umgebungsbedingungen ab. Wir können die Formulierung leicht anpassen, aber das könnte die Markteinführung verzögern.“

Projektleiter (A):

„Verstehe. Wenn wir die Formulierung anpassen – wie hoch ist das Risiko, dass wir komplett neue Tests benötigen?“

📌 Laut TPM könnte sich das System jetzt zu (1,1,1) entwickeln, da der Marketingspezialist (C) aktiviert wird.

🔄 Nächster Zustand: (1,1,1)

- Projektleiter bleibt aktiv (A=1)

- Wissenschaftler bleibt aktiv (B=1)

- Marketingspezialist wird aktiv (C=1)

📌 Schritt 3: Der Marketingspezialist steigt ein (Zustand: (1,1,1))

Marketingspezialist (C):

„Wir dürfen den Markteinführungstermin nicht gefährden. Gibt es eine Möglichkeit, eine alternative Produktionsmethode zu testen, die keine Verzögerung verursacht?“

Projektleiter (A):

„Das ist ein kritischer Punkt. Wissenschaftler, könnten wir Paralleltests durchführen, um Verzögerungen zu minimieren?“

Wissenschaftler (B):

„Theoretisch ja, aber das würde zusätzliche Ressourcen erfordern. Können wir kurzfristig zusätzliche Laborkapazitäten erhalten?“

📌 Laut TPM gibt es eine hohe Wahrscheinlichkeit, dass das System in (1,1,1) bleibt, da die Diskussion sehr aktiv ist.

🔄 Nächster Zustand: (1,1,1) bleibt erhalten

- Alle Rollen sind aktiv (A=1, B=1, C=1)

📌 Schritt 4: Diskussion über Lösungswege (Zustand: (1,1,1))

Projektleiter (A):

„Wenn wir alternative Tests durchführen, wie hoch ist die Wahrscheinlichkeit, dass wir die Stabilitätsprobleme vollständig lösen können?“

Wissenschaftler (B):

„Mit der aktuellen Datenlage würde ich sagen, dass wir eine Erfolgschance von 70 % haben. Aber wir brauchen eine genauere Simulation.“

Marketingspezialist (C):

„Dann brauchen wir eine Entscheidung: Ist es wirtschaftlich sinnvoller, jetzt auf die sichere Formulierung zu setzen oder das Risiko einer Optimierung einzugehen?“

📌 Laut TPM kann es nun zu einem Wechsel zu (1,0,1) oder (1,1,0) kommen, falls ein Akteur aus der Diskussion aussteigt.

🔄 Möglicher neuer Zustand: (1,1,0) oder (1,0,1)

- Wissenschaftler oder Marketingspezialist pausiert kurz.

📌 Schritt 5A: Wissenschaftler nimmt sich zurück (Zustand: (1,0,1))

Falls das System in (1,0,1) wechselt:

Projektleiter (A):

„Dann müssen wir schnell eine Entscheidung treffen. Können wir mit der aktuellen Testkapazität arbeiten?“

Marketingspezialist (C):

„Ich werde mit der Produktionsabteilung sprechen, um die Kapazitäten zu evaluieren. Falls wir eine beschleunigte Testphase realisieren können, sollten wir das so bald wie möglich tun.“

Projektleiter (A):

„Okay, dann priorisieren wir das. Ich brauche bis Ende der Woche eine Einschätzung.“

📌 Der Wissenschaftler pausiert, daher bleibt die Diskussion strategischer.

🔄 Möglicher neuer Zustand: (1,0,1) bleibt bestehen oder zurück zu (1,1,1)

📌 Schritt 5B: Marketingspezialist tritt zurück (Zustand: (1,1,0))

Falls das System in (1,1,0) wechselt:

Projektleiter (A):

„Wir brauchen eine sofortige Entscheidung. Ist eine Anpassung der Formulierung sicher und innerhalb unserer Zeitvorgaben machbar?“

Wissenschaftler (B):

„Ja, aber wir müssen die neuen Tests sehr sorgfältig planen. Ich erstelle eine Simulation und gebe euch in zwei Tagen ein Feedback.“

Projektleiter (A):

„In Ordnung, wir planen erst mal so. Falls sich aus den Simulationen neue Risiken ergeben, passen wir nach.“

📌 Der Marketingspezialist tritt zurück, daher ist die Diskussion technischer fokussiert.

🔄 Möglicher neuer Zustand: (1,1,0) bleibt bestehen oder zurück zu (1,1,1)

📌 Schritt 6: Entscheidung und Abschluss

Je nach letztem Zustand fällt das Team eine Entscheidung:

Option 1: (1,1,1) → Alle bleiben aktiv:

Projektleiter (A):

„Dann legen wir los. Wissenschaftler, Sie planen die Simulation. Marketingspezialist, Sie prüfen, ob wir die Tests beschleunigen können. Ich koordiniere die Ressourcen.“

Option 2: (1,1,0) → Wissenschaftlicher Fokus:

Projektleiter (A):

„Wissenschaftler, priorisieren Sie die Tests. Wir brauchen bald Klarheit, ob wir die Markteinführung verschieben müssen.“

Option 3: (1,0,1) → Wirtschaftlicher Fokus:

Projektleiter (A):

„Marketingspezialist, stellen Sie sicher, dass die Finanzierungsoptionen geprüft werden. Falls wir mehr Budget für schnellere Tests benötigen, müssen wir das sofort klären.“

📌 Finaler Zustand: (1,1,1) oder eine der Alternativen.

Falls du weitere Anpassungen möchtest oder bestimmte Elemente noch stärker optimiert werden sollen, lass es mich wissen! 😊🚀

Du:

Wie ist in dieser Sequenz die connectivity matrix berücksichtigt?

ChatGPT:

Die Connectivity Matrix bestimmt, welche Rollen direkt miteinander interagieren können. Ich werde jetzt Schritt für Schritt erklären, wie sie in der Kommunikationssequenz berücksichtigt wurde.

🔹 Connectivity Matrix in unserem Modell

Die Connectivity Matrix ist definiert als:

connectivity_matrix = np.array([

[1, 1, 0], # A beeinflusst A & B, aber nicht C

[0, 1, 1], # B beeinflusst sich selbst & C, aber nicht A

[1, 1, 1] # C beeinflusst alle (A, B, C)

])

📌 Bedeutung:

- Projektleiter (A) beeinflusst sich selbst und den Wissenschaftler (B), aber nicht direkt den Marketingspezialisten (C).

- Wissenschaftler (B) beeinflusst sich selbst und den Marketingspezialisten (C), aber nicht direkt den Projektleiter (A).

- Marketingspezialist (C) beeinflusst alle.

🔹 Wie beeinflusst die Connectivity Matrix die Kommunikationssequenz?

Die CM (Connectivity Matrix) gibt an, welche Rollen direkt miteinander kommunizieren können. Ich stelle jetzt dar, wie das in der Sequenz berücksichtigt wurde.

📌 Schritt 1: Projektleiter eröffnet die Diskussion (Zustand: (1,0,0))

Warum kann der Projektleiter direkt mit dem Wissenschaftler (B) sprechen?

🔹 Laut CM:

A→B

✔ Korrekt umgesetzt:

- Der Projektleiter spricht zuerst, da er die Diskussion leitet.

- Wissenschaftler (B) antwortet in Schritt 2, da er direkt vom Projektleiter beeinflusst werden kann.

Warum spricht der Marketingspezialist (C) noch nicht?

🔹 Laut CM:

A→/C (Anm.: d.h. A kann C nicht beeinflussen)

✔ Richtig:

- Der Marketingspezialist wird erst aktiviert, wenn B aktiv ist, da B →C eine erlaubte Verbindung ist.

📌 Schritt 2: Wissenschaftler bringt erste Analysen ein (Zustand: (1,1,0))

Warum antwortet jetzt der Wissenschaftler?

🔹 Laut CM:

A→B

✔ Korrekt umgesetzt:

- Der Projektleiter fragt den Wissenschaftler, wie die Stabilität beeinflusst wird.

- Der Wissenschaftler kann antworten.

Warum bleibt C inaktiv?

🔹 Laut CM:

A→B, B→C

✔ Richtig:

- Marketingspezialist (C) bleibt inaktiv, bis B ihn aktiviert.

📌 Übergangswahrscheinlichkeit in der TPM:

Laut TPM hat C eine hohe Wahrscheinlichkeit, aktiviert zu werden, wenn B aktiv ist.

🔄 Nächster Zustand: (1,1,1)

- Marketingspezialist wird aktiviert.

📌 Schritt 3: Marketingspezialist wird aktiv (Zustand: (1,1,1))

Warum kann C jetzt sprechen?

🔹 Laut CM:

B→C, C→A,B

✔ Korrekt umgesetzt:

- Der Marketingspezialist wird durch den Wissenschaftler aktiviert.

- C kann nun mit A und B interagieren, weil C alle beeinflussen kann.

Warum kann A jetzt mit C sprechen, obwohl es in der CM nicht direkt erlaubt ist?

✔ Indirekt über B möglich:

- A beeinflusst B

- B beeinflusst C

- Damit kann eine Kommunikation von A zu C stattfinden.

📌 Übergangswahrscheinlichkeit in der TPM:

Da jetzt alle Rollen aktiv sind, bleibt das System mit hoher Wahrscheinlichkeit in (1,1,1).

📌 Schritt 4: Diskussion über Lösungswege (Zustand: (1,1,1))

Warum sprechen jetzt alle Akteure in einem freien Dialog?

✔ Laut CM:

- C beeinflusst alle (A, B, C)

- B beeinflusst C, aber nicht A

- A beeinflusst B, aber nicht C

Korrekte Umsetzung:

- Der Projektleiter fragt etwas (A)

- Der Wissenschaftler gibt eine Analyse (B)

- Der Marketingspezialist betrachtet die wirtschaftlichen Aspekte (C)

📌 Übergangswahrscheinlichkeit in der TPM:

- Das System kann stabil in (1,1,1) bleiben, aber ein Akteur kann aus der Diskussion aussteigen.

🔄 Möglicher Zustand: (1,1,0) oder (1,0,1)

- Falls B pausiert → (1,0,1)

- Falls C pausiert → (1,1,0)

📌 Schritt 5A: Wissenschaftler tritt zurück (Zustand: (1,0,1))

Warum ist das ein realistischer Übergang?

🔹 Laut CM:

C→A

✔ Korrekt umgesetzt:

- Der Marketingspezialist übernimmt die wirtschaftlichen Fragen.

- Der Wissenschaftler tritt zurück, um Daten zu sammeln.

📌 Schritt 5B: Marketingspezialist tritt zurück (Zustand: (1,1,0))

Warum konzentriert sich die Diskussion jetzt auf Wissenschaft & Strategie?

🔹 Laut CM:

A→B

✔ Korrekt umgesetzt:

- Wissenschaftler fokussiert sich auf technische Details.

- Projektleiter bleibt strategisch aktiv.

📌 Übergangswahrscheinlichkeit in der TPM:

- Falls der Marketingspezialist keine neuen Inputs hat, kann er inaktiv bleiben.

Zusammenfassend: Dieses kleine Kommunikationsbeispiel zeigt, dass die IIT-Netzwerke auch als Team-Kommunikations-Netzwerke interpretiert werden können: Ich habe dies nicht für alle möglichen Netzwerke gezeigt, jedoch ist für mich nicht erkennbar, wieso ein beliebiges Netzwerk nicht auch eine beliebige Team-Kommunikation repräsentieren kann. Das heißt auch, dass Teams genau die gleichen Phi-Werte erreichen können, wie kognitive Systeme, also Individuen: Prinzipell kann der Collective Mind eines Teams, hier gemessen über Phi, hohe Synergiewerte annehmen.

Hier zeigt sich meines Erachtens aber auch sehr stark die Erkenntnis-Lücke in der IIT: Es ist schwer vorstellbar, dass Teams über das gleiche Bewusstsein verfügen wie Menschen. – Wie schon im letzten Blog angesprochen, zeigt dies, dass in der IIT etwas Grundsätzliches fehlt, um menschliches Bewusstsein zu beschreiben.

[1] Albantakis L, et al. (2023) Integrated information theory (IIT) 4.0: Formulating the properties of phenomenal existence in physical terms. PLoS Comput Biol 19(10): e1011465, https://doi.org/10.1371/journal.pcbi.1011465

[2] PyPhi (2024) Phi Python Bibliothek, https://pyphi.readthedocs.io/en/latest/index.html