Unsere Glaubenssätze haben uns fest im Griff:

„Autobahn ohne Tempolimit, ist Ausdruck unserer deutschen Freiheit.“, „Jedem Bürger seine Waffen, ist Ausdruck amerikanischer Freiheit.“, „Klimawandel ist das Hirngespinst der Grünen.“

oder

„Maschinen sind allenfalls kompliziert, aber nicht komplex. Wir sind komplex.“, „Die belebte Natur ist was ganz anderes als die unbelebte Natur“, „Wir Menschen haben Bewusstsein, sonst niemand und nichts.“ „Wir Menschen sind die Krönung der Schöpfung.“ „Management und Führung sowie AI schließen sich aus.“

Sehr oft sind diese Glaubenssätze mit unserer Fähigkeit verbunden, Kategorien zu bilden, wie komplex-nicht komplex, belebt-unbelebt, bewusst-unbewusst, wertvoll-weniger wertvoll, emotional-mechanisch.

Ich habe einen Glaubenssatz, es ist wieder nur ein Glaubenssatz 😉, der insbesondere diese letzten Glaubenssätze auflöst. – Ich glaube, dass unser Sein nicht-teilbar ist. Ich will versuchen, diesen Glaubenssatz zu erläutern, in dem ich die letzten oben genannten Glaubenssätze aus dieser Perspektive betrachte:

(Mechanische) Maschinen zeigen tatsächlich, unter normalen Bedingungen, lediglich einfaches oder kompliziertes Verhalten. – Sie sind gerade so konzipiert, dass sie kein komplexes Verhalten zeigen sollen. Jedoch nicht selten zeigen sie es, wenn sie unter „Stress“ geraten.- „Stress“ heißt in diesem Fall, die Maschinen geraten in den Grenzbereich ihrer Nutzung. Es gibt aber auch immer mehr Maschinen, also von uns Menschen hergestellte Systeme, wie z.B. den Laser oder die AI Systeme, die gerade auf Komplexität und der damit verbundenen Selbstorganisation beruhen. Der Glaubenssatz, dass nur lebende oder soziale Objekte komplex sind, ist unserer bisherigen Naivität und unserer Mensch-Zentrierung geschuldet.

Nach der „Erschaffung“ der unbelebten Natur vor einigen Milliarden Jahren, gab es meines Erachtens keinen Eingriff eines Gottes oder Etwas Ähnliches, das der unbelebten Natur Leben einhauchte.- Und damit neue (uns noch weitgehend unbekannte) Prinzipien des Lebens explizit neu einbrachte. Vielmehr glaube ich, dass die unbelebte Natur alles enthält, um belebte Natur zu entwickeln.

Ähnlich glaube ich, dass die (uns ebenfalls noch unbekannten) Prinzipien, die zu Bewusstsein führen, schon in der unbelebten und belebten Natur vorhanden sind. – Und, dass wir Menschen lediglich ein Produkt der Entfaltung der fundamentalen Prinzipien des Seins sind. Damit ist auch gleichzeitig gesagt, dass wir wahrscheinlich nicht das letzte Produkt dieser Entfaltung sind, sondern vielleicht lediglich ein Zwischenergebnis.

Die Kategorien-Bildung hilft uns, die Welt Stück für Stück besser zu verstehen und Stück für Stück auf fundamentalere Prinzipien zurückzuführen. – Leider bleiben wir oft an den Kategorien vergangener Erkenntnis kleben und weisen ihnen eigenständige fundamentale Prinzipien zu.

Vor kurzem ging durch die Presse, dass AI Entwickler behaupten, dass große AI Systeme Bewusstsein entwickelt haben oder zu mindestens „ein bisschen davon“. – Andere tun dies wiederum als völligen Unsinn ab [1], [2]. Da wir bisher nicht wissen, was Bewusstsein ist, können wir auch nicht sagen, ob es schon AI Systeme mit Bewusstsein oder „ein bisschen Bewusstsein“ gibt. Entsprechend meinem obigen Glaubenssatz glaube ich jedoch, dass es irgendwann AI Systeme mit Bewusstsein geben wird, ob morgen oder erst in 1000 Jahren vermag ich nicht zu sagen. Da unser Sein ein nicht-teilbares Sein ist, glaube ich, dass es nur eine Frage der Zeit ist, bis von uns geschaffene Systeme mit Bewusstsein existieren werden. Der Deep-Learning-Pionier Yann LeCun hat auch schon wieder einen (altbekannten) Lösungsweg aufgetan: Bewusstsein benötigt eine System-Architektur, die unserer Gehirn-Architektur nachempfunden ist [3].

Schon heute erscheinen täglich neue Meldungen, zu den erstaunlichen Aussagen und Leistungen von AI Systemen. So betont beispielsweise eine Zeitschrift die Gefahren, die von AI Systemen ausgehen können, indem sie titelt „Künstliche Intelligenz droht im Gespräch „die Menschen auszuschalten““ [4]. In der sehr seriösen Zeitschrift Scientific American war unlängst von einer AI zu lesen, die einen wissenschaftlichen Artikel über sich selbst geschrieben hat.- Die Entwickler der AI haben diesen Artikel als wissenschaftlichen Artikel zum Peer-Review eingereicht [5].

Man stelle sich nur vor, die Entwicklung der AI würde ähnlich schnell und fundamental weiter gehen wie in den letzten 10 Jahren und in 10 Jahren hätten wir AI Systeme mit einer Allgemeinen Künstlichen Intelligenz, die zudem (erste) Anzeichen von Bewusstsein zeigen würde. Müssten wir dann unsere menschenzentrierte Ethik nicht völlig neu denken. Denn es kämen dann zwangsläufig Fragen auf wie „Ist es ethisch vertretbar, eine AI mit Bewusstsein bei Bedarf abzustellen?“, oder „Müssten wir solchen AI Systemen Rechte einräumen?“.

Wie in meinem Blog-Beitrag vom Februar 2022 dargelegt, ist die bisherige angedachte Ethik der EU zu AI Systemen eine human-centric perspective.

Der sogenannte EU AI Act basiert auf den europäischen Werten und soll insbesondere die Menschen vor Schaden schützen [6]:

“Aside from the many beneficial uses of artificial intelligence, that technology can also be misused and provide novel and powerful tools for manipulative, exploitative and social control practices. Such practices are particularly harmful and should be prohibited because they contradict Union values of respect for human dignity, freedom, equality, democracy and the rule of law and Union fundamental rights, including the right to non-discrimination, data protection and privacy and the rights of the child.”

Ziel der EU ist es, AI Systeme zu erlauben, denen wir trauen können, also sogenannte Trustworthy AI. An dieser Forderung ist „fast“ nicht auszusetzen, wenn man davon absieht, dass die Natur und die Tiere lediglich in drei Sätzen eines ca. 100 Seiten starken Proposal Dokumentes auftauchen.

Warum ist mir eine ganzheitliche Sicht mit entsprechender Ethik so wichtig? Um diese Frage zu beantworten, möge man sich nur Folgendes fragen: Welche Ethik und damit Rechtsverständnis macht(e) es möglich, dass über Jahrzehnte das millionenfache Töten von männlichen Küken durchgeführt wurde? Welche Ethik und damit Rechtsverständnis macht(e) es möglich, dass Bauern das Grundwasser durch Überdüngung belasten dürfen?

Heute ist aus diesen unethischen Gewohnheiten Gewohnheitsrecht geworden. Es basieren Geschäftsmodelle auf diesem Mangel an ganzheitlicher Ethik und es bedarf enormer Anstrengungen, dieses Gewohnheitsrecht durch ein ethisch fundiertes Recht abzulösen. Denn der Mangel an einer ganzheitlichen Ethik hat dazu geführt, dass wir uns immer wieder in verschiedene Dilemmata bringen: Z.B. stellt sich die Frage, ob es erlaubt ist, die Lebensgrundlage der Bauern zu gefährden, in dem wir das Grundwasser (nachträglich) schützen. Wäre es nicht sinnvoll gewesen, den Schutz des Grundwassers von vorneherein zu gewährleisten und den Bauern und der Gesellschaft die Möglichkeit zu geben, ganzheitliche ethische Geschäftsmodelle zu entwickeln.

Die Diskussion zur AI Ethik [7] und die damit verbundenen Rechtsvorschläge, wie den EU AI Act, beruhen auf keiner ganzheitlichen Ethik: Die Rechte von Natur und Tieren sind nicht berücksichtigt und die ethischen Konsequenzen, die sich aus einer möglichen Entwicklung von AI Systemen in Richtung einer Allgemeinen Künstlichen Intelligenz ergeben, sind noch nicht einmal ansatzweise enthalten.

Ich komme zur aktuellen Version des Proposals EU AI Act zurück und skizziere die schon heute absehbaren großen Anforderungen an das (Projekt) Management:

Als guten Einstieg in den EU AI Act [6] dient das sogenannte Briefing des European Parliamentary Research Service [8]: Der EU AI Act ist ein Risiko-basierter Ansatz, in dem AI-Systeme in vier Risikokategorien eingeteilt werden: „AI systems posing (i) unacceptable risk, (ii) high risk, (iii) limited risk, and (iv) low or minimal risk.“ Eine genaue Definition, wann welche Kategorie vorliegt, gibt es leider nicht, jedoch gibt es Beispiele, insbesondere zur Kategorie „unacceptable risk“ und „high risk“:

Unacceptable risk AI Systeme sind in der EU verboten, z.B. [6, 8]:

- AI systems that deploy harmful manipulative ’subliminal techniques‘

- AI systems that exploit specific vulnerable groups (physical or mental disability)

- AI systems used by public authorities, or on their behalf, for social scoring purposes

- ‚Real-time‘ remote biometric identification systems in publicly accessible spaces for law enforcement purposes, except in a limited number of cases

High-risk AI Systeme sind erlaubt, unterliegen jedoch sehr strengen Auflagen, z.B. [6,8]:

- High-risk AI systems used as a safety component of a product or as a product falling under Union health and safety harmonisation legislation (e.g. toys, aviation, cars, medical devices, lifts)

- High-risk AI systems deployed in eight specific areas identified in Annex III of the EU AI Act, which the Commission would be empowered to update as necessary by way of a delegated act

- Biometric identification and categorisation of natural persons

- Management and operation of critical infrastructure

- Education and vocational training

- Employment, worker management and access to self-employment

- Access to and enjoyment of essential private services and public services and benefits

- Law enforcement

- Migration, asylum and border control management

- Administration of justice and democratic processes

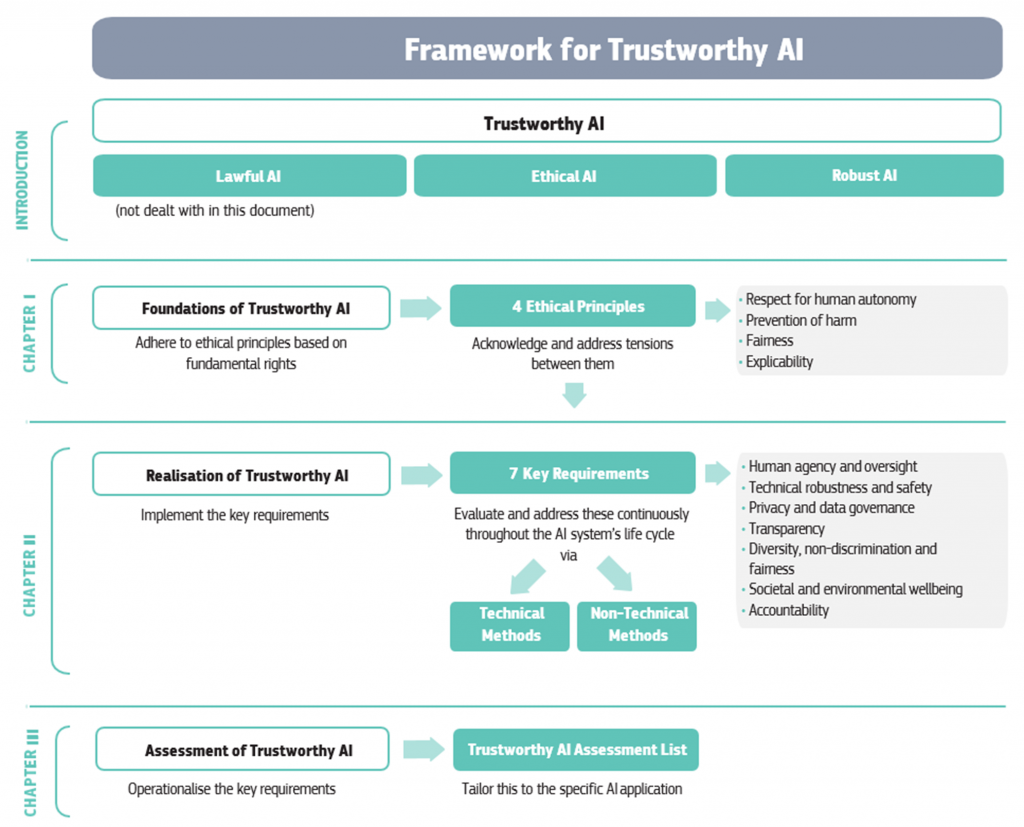

Die EU High-Level Expert Group on Artificial Intelligence hat den “Mangel” an Operationalisierbarkeit des EU AI Act erkannt und das Dokument „Ethics Guidelines for Trustworthy AI“ erstellt [9]. Spätestens beim Lesen dieses Dokumentes wird einem sehr schnell klar, dass der EU AI Act für Organisationen und insbesondere hier das Projekt-, Risiko- und Qualitätsmanagement weitreichende Konsequenzen haben wird. Die Transparenz-, Dokumentations- und Monitoring-Anforderungen während des gesamten (!) Lebenszyklus eines AI Systems (alleinstehend oder embedded) sind enorm. Ich verweise auf [9] und die darin enthaltene mehrseitige Checkliste.

Ich stelle die Frage, zu welcher Kategorie gehören die beiden Machbarkeitsprototypen, die ich in den letzten beiden Blog-Beiträgen vorgestellt habe? – Und gebe einen ersten Einblick in die in dem EU AI Act enthaltenen Anforderungen.

Gehe ich von den oben auf geführten Beispielen aus, so gehören meine Machbarkeitsprototypen in die high-risk Kategorie „Education and vocational training“ und in die Kategorie „worker management“. In [9] ist die Abbildung 1 enthalten, die die zentralen Anforderungen an eine Trustworthy AI enthält:

Ich skizziere anhand dieser Abbildung meine Einschätzung bezüglich der Vertrauenswürdigkeit der beiden Machbarkeitsprototypen:

|

|

Collective Mind proxy auf der Basis der Similarity Matrix |

Collective Mind Netzwerk auf der Basis eines Graphical Networks |

|

Ethical Principles |

|

|

|

Respect for human autonomy |

Die menschliche Autonomie wird nicht aktiv eingeschränkt, Kritiker könnten jedoch einwenden, dass die Quantifizierung von Ähnlichkeit in den Aussagen zu einer passiven Autonomieverletzung führt. |

Die menschliche Autonomie wird weder aktiv noch passiv in der aktuellen Version eingeschränkt. Es lassen sich jedoch Zuordnung von Begriffen und Personen vornehmen, so dass die Kritik der passiven Autonomieeinschränkung je nach Nutzung evtl. vorhanden ist. |

|

Prevention of harm |

Physischer Schaden kann nicht eintreten. Psychischer Schaden könnte eintreten, wenn die vorhandene oder nicht vorhandene Similarity von Vorgesetzten/Kollegen als Druckmittel eingesetzt wird. |

Physischer Schaden kann nicht eintreten. Psychischer Schaden könnte eintreten, wenn eine Verbindung zwischen Person und graphischen Netzwerkknoten von Vorgesetzten/Kollegen mit amoralischer Absicht benutzt wird. |

|

Fairness |

Das AI System trifft keine unfairen Aussagen, jedoch könnte dies evtl. durch beteiligte Stakeholder, wie oben geschildert, erfolgen. |

Das AI System trifft keine unfairen Aussagen, jedoch könnte dies evtl. durch beteiligte Stakeholder, wie oben geschildert, erfolgen. |

|

Explicability |

Die Verständlichkeit und Transparenz des Algorithmus ist (nahezu) vollständig gegeben, auch wenn man berücksichtigen sollte, dass diverse Fremd-Softwaremodule (u.a. word2vec, spaCy) verwendet werden. |

Die Verständlichkeit und Transparenz des Algorithmus ist (nahezu) vollständig gegeben, auch wenn man berücksichtigen sollte, dass diverse Fremd-Softwaremodule (u.a. spaCy, Transformer Pipeline) verwendet werden. |

|

7 Key Requirements |

|

|

|

Human agency and oversight |

Die Anwendung der AI liegt vollkommen in den Händen der Nutzer. Dies setzt voraus, dass die Ergebnisse der Anwendung nur den direkten Nutzern zugänglich gemacht werden. |

Die Anwendung der AI liegt vollkommen in den Händen der Nutzer. Dies setzt voraus, dass die Ergebnisse der Anwendung nur den direkten Nutzern zugänglich gemacht werden. |

|

Technical robustness and safety |

Die Anwendung ist äußerst robust (u.a. gibt es kein AI Lernen während des Betriebs) und hat keine sicherheitsrelevanten Auswirkungen. |

Die Anwendung ist äußerst robust (u.a. gibt es kein AI Lernen während des Betriebs) und hat keine sicherheitsrelevanten Auswirkungen. |

|

Privacy and data governance |

Es werden keinerlei persönliche Daten erhoben, wenngleich die Daten mittels weiterer Techniken oder manuell Personen zugeordnet werden können und damit prinzipiell auch eine indirekte Verletzung der Privatsphäre möglich ist. Um dies zu verhindern ist eine data governance in nutzenden Organisationen erforderlich. |

Es werden keinerlei persönliche Daten erhoben, wenngleich die Daten mittels weiterer Techniken oder manuell Personen zugeordnet werden können und damit prinzipiell auch eine indirekte Verletzung der Privatsphäre möglich ist. Um dies zu verhindern ist eine data governance in nutzenden Organisationen erforderlich. |

|

Transparency (Diese Schlüsselanforderung ist direkt eine Konsequenz des ethischen Prinzips Explicability.) |

Wie in [10] dargelegt hängt die Transparenz von mehreren Faktoren ab: Erklärbare Algorithmen, Einsicht in den Trainingsdatensatz, Einsicht in die Datensatzauswahl, Erkennen von Mentalen Verzerrungen im ausgewählten Datensatz, Transparenz bzgl. der verwendeten Modellversionen. Bzgl. word2vec, spaCy ist die Umsetzung dieser Anforderungen mit meinen Zugriffsrechten und meinem Kenntnisstand nicht möglich. Da das Ergebnis jedoch lediglich ein word-embedding darstellt, erscheint mir der potenzielle Missbrauch äußerst gering. |

Wie in [10] dargelegt hängt die Transparenz von mehreren Faktoren ab: Erklärbare Algorithmen, Einsicht in den Trainingsdatensatz, Einsicht in die Datensatzauswahl, Erkennen von Mentalen Verzerrungen im ausgewählten Datensatz, Transparenz bzgl. der verwendeten Modellversionen. Bzgl. Transformator Pipeline und spaCy ist die Umsetzung dieser Anforderungen mit meinen Zugriffsrechten und meinem Kenntnisstand nicht möglich. Da das Ergebnis jedoch lediglich einen Graph darstellt erscheint mir der potenzielle Missbrauch äußerst gering. |

|

Diversity, non-discrimination and fairness |

Das AI System nimmt keine wie auch immer geartete Diskriminierung vor: Jedoch könnte durch die entstandene Transparenz im Meinungsspektrum und einer entsprechenden Zuordnung zu Personen, Missbrauch möglich sein. |

Das AI System nimmt keine wie auch immer geartete Diskriminierung vor: Jedoch könnte durch die entstandene Transparenz im Meinungsspektrum und einer entsprechenden Zuordnung zu Personen, Missbrauch möglich sein. |

|

Societal and environmental wellbeing |

Gesellschaft und Umwelt werden in keiner Form beeinflusst. Sollten solche oder ähnliche Systeme eingesetzt werden ist jedoch zu beachten, dass evtl. die Akzeptanz oder Nicht-Akzeptanz für AI-System steigt. Eine unreflektierte Nutzung ohne ein Minimum an technischer und ethischer Bildung erscheint nicht sinnvoll, da dies mit unbekannten Risiken verbunden sein kann. Man siehe auch die entsprechenden Anforderungen bzgl. Professionalisierung von Teams bzgl. AI und Ethik in [7]. |

Gesellschaft und Umwelt werden in keiner Form beeinflusst. Sollten solche oder ähnliche Systeme eingesetzt werden ist jedoch zu beachten, dass evtl. die Akzeptanz oder Nicht-Akzeptanz für AI-System steigt. Eine unreflektierte Nutzung ohne ein Minimum an technischer und ethischer Bildung erscheint nicht sinnvoll, da dies mit unbekannten Risiken verbunden sein kann. Man siehe auch die entsprechenden Anforderungen bzgl. Professionalisierung von Teams bzgl. AI und Ethik in [7]. |

|

Accountability |

Der EU AI Act sieht die Rechenschaftspflicht sehr stark beim Hersteller der AI Systeme. Ich empfehle, dass daneben eine Rechenschaftspflicht der nutzenden Organisation tritt, denn so wie man ein Messer zum Aufschneiden eines Apfels oder alternativ zum Töten eines Menschen benutzen kann, kann man jedes AI System unethisch anwenden. |

Der EU AI Act sieht die Rechenschaftspflicht sehr stark beim Hersteller der AI Systeme. Ich empfehle, dass daneben eine Rechenschaftspflicht der nutzenden Organisation tritt, denn so wie man ein Messer zum Aufschneiden eines Apfels oder zum Töten eines Menschen benutzen, kann man jedes AI System unethisch anwenden. |

Zusammenfassend stelle ich fest, dass eine ganzheitliche Ethik u.a. im Lichte aktueller AI Entwicklungen notwendig ist, dass ein Mangel an ganzheitlicher Ethik hohe Risiken in sich birgt, und dass der EU AI Act nur ein erster Schritt in diese Richtung ist. Gleichwohl sind die Anforderungen an das Management schon mit der aktuellen Proposal Version des EU AI Act sehr groß.

[1] Stieler W (2022) Hat KI bereits eine Art Bewusstsein entwickelt? Forscher streiten darüber, https://www.heise.de/hintergrund/Hat-KI-bereits-eine-Art-Bewusstsein-entwickelt-Forscher-streiten-darueber-6522868.html , zugegriffen am 22.07.2022

[2] Eisenlauer M (2022) google Entwickler sicher – Künstliche Intelligenz hat eigenes Bewusstsein, https://www.bild.de/digital/computer/computer/hat-googles-kuenstliche-intelligenz-lamda-ein-bewusstsein-entwickelt-80393376.bild.html

[3] Dickson B (2022) Meta’s Yann LeCun on his Vision for human-level AI, TechTalks, https://bdtechtalks.com/2022/03/07/yann-lecun-ai-self-supervised-learning/, zugegriffen am 06.07.2022

[4] Mey S (2022) Künstliche Intelligenz droht im Gespräch „die Menschen auszuschalten“, DerStandard, https://www.derstandard.de/story/2000136591877/kuenstliche-intelligenz-droht-im-gespraech-die-menschen-auszuschalten?ref=rss , zugegriffen am 06.07.2022

[5] Thunström A O (2022) We Asked GPT-3 to Write an Academic Paper about Itself—Then We Tried to Get It Published, Scientific American, https://www.scientificamerican.com/article/we-asked-gpt-3-to-write-an-academic-paper-about-itself-then-we-tried-to-get-it-published/, zugegriffen am 06.07.2022

[6] EU AI Act (2022) https://artificialintelligenceact.eu/, Europe Administration, zugegriffen am 06.07.2022

[7] Blackman R (2022) Ethical Machines: Your concise guide to totally unbiased, transparent and respectful AI, Harvard Business Review Press, kindle edition

[8] European Parliamentary Research Service (2022) Briefing EU AI Act, https://www.europarl.europa.eu/thinktank/en/document/EPRS_BRI(2021)698792

[9] High-Level Expert Group on Artificial Intelligence (2022) ETHICS GUIDELINES FOR TRUSTWORTHY AI, https://ec.europa.eu/futurium/en/ai-alliance-consultation.1.html [10] Schmelzer R (2022) Towards a more transparent AI, Forbes, https://www.forbes.com/sites/cognitiveworld/2020/05/23/towards-a-more-transparent-ai/?sh=725c89d33d93

[10] Schmelzer R (2022) Towards a more transparent AI, Forbes, https://www.forbes.com/sites/cognitiveworld/2020/05/23/towards-a-more-transparent-ai/?sh=725c89d33d93