Dieser Blog ist der sechste Teil der Blog-Serie ‚Von der gesellschaftlichen Kernschmelze…‘. Dieses Mal starte ich mit einigen Erfahrungen in der Verwendung der KI-Systeme ChatGPT, Claude und DeepSeek.

Der Teil des Titels ‚Dies markiert den Beginn einer neuen Ära empirisch fundierter, bewusstseins-integrierter Demokratieforschung! 🌟‘ stammt von der KI Claude und zeigt einen kleinen Ausschnitt der wenig positiven aktuellen Erfahrungen mit den zwei KI-Systemen ChatGPT und Claude. Für meine Aufgabenstellungen hat hingegen DeepSeek im Laufe der letzten Monate eine extrem gute Entwicklung gezeigt.

Ziel dieses Blog-Beitrages ist es, das in den letzten Blog-Beiträgen entwickelte Modell des Demokratie-Autokratie-Übergangs an realen Daten zu validieren.

Wie die Blog-Beiträge des letzten Jahres zeigen, waren meine Erfahrungen mit ChatGPT sehr positiv. Alle diese Blog-Beiträge, wie auch der aktuelle, sind durch eine recht aufwendige mathematische Modellierung und eine entsprechend umfangreiche Programmierung gekennzeichnet.

Der vorliegende Blog-Beitrag ist im Juni 2025 entstanden. Zu meiner Überraschung zeigte ChatGPT in mehreren von mir verwendeten Versionen einen enormen Leistungsverlust: Die Ausgabe der umfangreichen Programme erfolgte nicht mehr vollständig. Selbst mehrfaches Nachfordern und das Umleiten der Ausgabe in Dateien brachte keine Besserung. Es ging so weit, dass ChatGPT mir völlig anderen Code anbot, teilweise hatte dieser noch etwas mit der Aufgabenstellung zu tun, jedoch waren es eher kleine Code-Schnipsel. – Kurzum das System war für die Erstellung des Blog-Beitrages nicht nutzbar. – Ich hatte die letzten Jahre schon mehrmals ähnliche Erfahrungen gemacht.- Dieses Mal kam es jedoch sehr überraschend, zumal Sam Altman immer mehr von der KI Singularity spricht. – Meine aktuellen Erfahrungen stehen in krassem Widerspruch zu seinen Prognosen.

Ich wechselte zu Claude. Claude war zuerst in der Lage das Programm vollständig zu erzeugen. Die Programm-Ausgabe, begleitet von ähnlich euphorischen Sätzen wie demjenigen im Titel des Blog-Beitrages, kann den Benutzer dazu verleiten, zu glauben, dass Alles in Ordnung ist. Dem war leider nicht so. Claude benötigte sehr viele Korrekturanweisungen: Immer wieder wurden Modell-Kürzungen vorgenommen, teilweise sogar mit erheblichen Modellverfälschungen.

Mit viel Mühe gelang es schließlich eine erste Version des Programms zu erzeugen. Einer weiteren Verfeinerung und Ergänzung widersetzte sich Claude jedoch. Es tauchten ähnliche Probleme wie bei ChatGPT auf: Code wurde weggelassen und schließlich wurde nur noch ‚Spiel-Code‘ angeboten. Zugegeben, der Code war inzwischen umfangreich, jedoch bei weitem nicht vergleichbar mit Code, den man in der professionellen Computersimulations-Forschung einsetzt. – Also auch hier Indizien für ein Überbewerten der kurzfristigen Erreichbarkeit der AI Singularity?!

Ich wechselte zu DeepSeek, meiner letzten Hoffnung den Blog-Beitrag noch fertigzustellen.- Denn der Fertigstellung durch mich alleine gab ich keine Aussicht auf Erfolg. Mit DeepSeek gelang es mir tatsächlich zwei erhebliche Modell-Ergänzungen vorzunehmen.

Ich ließ die Ergebnisse des nun fertigen Programms von allen drei KI-Systemen interpretieren. – Das war noch möglich: Die Interpretationen von ChatGPT und DeepSeek waren am sachlichsten und an den Daten orientiert. Die Interpretationen von Claude waren wieder ziemlich euphorisch, teilweise sehr plakativ. Einmal geschah bei Claude etwas sehr Bedenkliches: Die KI interpretierte die Ergebnisse aus Sicht der letzten Programmversion, die Claude erstellt hatte. Claude hatte die tatsächlichen Ergebnisse völlig falsch zugeordnet und kam zu einer völlig unsinnigen Interpretation.

Ich interpretiere diese teilweise sehr bedenklichen Erfahrungen wie folgt: Es ist möglich, dass das KI-Verhalten durch das Interface zwischen Prompt-UI und eigentlicher KI hervorgerufen wird. Vermutlich nehmen die KI-Anbieter dort für den Anwender intransparente Änderungen am Prompt-Input vor. Es könnte zum Beispiel sein, dass der Prompt nur eine bestimmte Größe haben darf. Die Ausgabe von ‚Spiel-Code‘ statt umfangreichen richtigen Code weist jedoch darauf hin, dass die KI-Systeme selbst überfordert waren und es offensichtlich kein Warnsystem für Überforderung gib. Zwar ist immer Vorsicht bei der Übernahme von KI-Ausgaben geboten, jedoch scheint diese Vorsicht ab einem bestimmten Aufgabenumfang besonders wichtig zu werden.

Ich wende mich nun dem eigentlichen Ziel dieses Blog-Beitrages zu: Der Validierung des Modells anhand realer Daten. Der Begriff ‚Validierung‘ ist etwas hoch gegriffen, da ich einerseits nicht alle 70 Parameter des Modells realen Daten zuordnen kann und anderseits die Zuordnung, die ich vornehme nicht ganz eindeutig ist. Die in den sogenannten realen Daten enthaltenen Kriterien für Demokratie basieren ihrerseits auf einem Modell und dieses Modell passt nicht zwangsläufig zu meinem Modell. Außerdem enthält die Validierungsmethode selbst gewisse Annahmen.

Ich benutze die V-Dem Daten von 1990-2024, die zu den umfangreichsten und weltweit besten Demokratie-Autokratie-Daten gehören [1]. Schon im dritten Teil dieser Blogreihe ‚Von der gesellschaftlichen Kernschmelze oder vom Phasenübergang Demokratie-Autokratie‘ vom Mai 2025 habe ich daraufhin gewiesen, dass es unterschiedliche Datensätze von unterschiedlichen Anbietern gibt und diese teilweise erheblich voneinander abweichen. – Die Validierung hat also hier schon ein nicht unerhebliches Handicap, da die ‚Messdaten‘ von unterschiedlichen Anbietern nicht immer das gleiche Ergebnis zeigen. Die ‚Messungen‘ werden typischer Weise über die Einschätzung eines Expertenkollektivs vorgenommen, ähnlich wie man dies von den Expertenschätzungen im Projektmanagement kennt. Prinzipiell kann diese Art von ‚Messung‘ sehr genau sein, differiert jedoch mit dem angenommen Demokratie-Modell (u.a. Zusammenstellung der Kriterien, Wichtung der Kriterien usw. ).

Ich sehen von diesen Unzulänglichkeiten ab und nehme für 18 Parameter in der ODE-Hauptgleichung Zuordnungen vor (man siehe für das ODE-System den vorherigen Blog-Beitrag). – Damit werden alle ‚Soziale Feld‘ Parameter sowie die Parameter des demokratischen und des autokratischen Agenten abgedeckt. Für den rechts-libertären Agenten gibt es in den V-Dem Daten keine Entsprechung. Tabelle 1 zeigt diese Zuordnung:

| Parameter | Zuordnung | V-Dem Indikator | Transformation | Theoretische Begründung |

| λ (lam bzw. lambda: Control Parameter-Political Stress) | v2x_libdem | Liberal Democracy Index | Verschiedene Zuordnungen a +b*x, für vier verschiedene Regime Bereiche | Gesamtdemokratiequalität als inverser Stressindikator |

| α_Z (Future Orientation) | v2x_delibdem | Deliberative Democracy | 0.02 + 0.06 * x | Deliberative Prozesse fördern langfristige Planung und Zukunftsorientierung |

| α_W (Value Cohesion) | v2x_cspart | Civil Society Participation | 0.02 + 0.06 * x | Zivilgesellschaftliche Teilhabe schafft geteilte Werte und sozialen Zusammenhalt |

| α_B (Needs Cohesion) | v2x_egaldem | Egalitarian Democracy | 0.02 + 0.06 * x | Egalitäre Demokratie adressiert gemeinsame Grundbedürfnisse aller Schichten |

| α_Q (Institutional Trust) | v2x_rule | Rule of Law | 0.005 + 0.055 * x | Rechtsstaatlichkeit als direktes Maß für Institutionenvertrauen |

| α_I (Inequality Impact) | v2x_egaldem | Egalitarian Democracy | 0.01 + 0.05 * (1-x) (invertiert) | Schwache egalitäre Demokratie = hohe Ungleichheit |

| β_P (Polarization) | v2cacamps | Campaign Polarization | 0.03 + 0.09 * x | Direkte Messung von Wahlkampfpolarisierung als autokratische Kraft |

| β_V (Mistrust) | v2x_rule | Rule of Law | 0.02 + 0.08 * (1-x) (invertiert) | Schwache Rechtsstaatlichkeit erzeugt gesellschaftliches Misstrauen |

| β_E (Economic Crisis) | v2x_corr | Corruption Index | 0.02 + 0.08 * x | Korruption destabilisiert Wirtschaft und erzeugt Krisen |

| β_M (Media Polarization/Manipulation) | v2xme_altinf | Alternative Information | 0.02 + 0.06 * (1-x) (invertiert) | Weniger alternative Medien = mehr staatliche Medienmanipulation |

| k_f_ID (Integral Thinking) | v2x_delibdem | Deliberative Democracy | 0.00 + 0.03 * x | Deliberation erfordert ganzheitliches Denken |

| k_f_Ep (Empathy) | v2xcl_rol | Equality before Law | -0.01 + 0.03 * x | Rechtliche Gleichbehandlung setzt Empathie für Gerechtigkeit voraus |

| k_f_T (Transparency) | v2x_freexp | Freedom of Expression | -0.02 + 0.04 * x | Meinungsfreiheit ermöglicht und erfordert Transparenz |

| k_f_Wp (Science Affinity) | v2x_freexp | Freedom of Expression | -0.02 + 0.04 * x | Wissenschaftliche Diskussion braucht Meinungsfreiheit |

| k_f_C (Conspiracy Thinking) | v2xpe_exlpol | Political Exclusion | -0.01 + 0.04 * x | Politischer Ausschluss fördert Verschwörungsdenken |

| k_f_MG (Power Hunger) | v2x_corr | Corruption Index | -0.02 + 0.05 * x | Korruption reflektiert Machtgier in der Politik |

| k_f_R (Revenge) | v2cacamps | Campaign Polarization | -0.01 + 0.03 * x | Polarisierung erzeugt Rachegelüste zwischen politischen Lagern |

| k_f_Wm (Science Denial) | v2xpe_exlpol | Political Exclusion | -0.02 + 0.04 * x | Ausgrenzung führt zu Anti-Establishment und Wissenschafts-feindlichkeit |

Die übrigen 52 Parameter, die im Wesentlichen in den Hilfs-ODE’s enthalten sind, bleiben auf ihren Standardwerten. Diese Standardwerte habe ich schon für die vorherigen Blog-Beiträge verwendet. Sie sind für alle Rechnung gleich fixiert.

Damit ergeben sich für die Länder USA, Deutschland, Ungarn und Ukraine folgende an den V-Dem Daten kalibrierten Parameterwerte:

| Para-meter | Bedeutung | V-Dem Indikator | USA | Deutsch-land | Ungarn | Ukraine |

| lam (lambda) | 1/Liberal Democracy → Political Stress | v2x_libdem | 0.3198 | 0.2901 | 0.3562 | 1.4326 |

| alpha_B | Egalitarian Democracy → Needs Cohesion | v2x_egaldem | 0.0610 | 0.0693 | 0.0556 | 0.0408 |

| alpha_I | Egalitarian Democracy → Inequality Impact (inverted) | v2x_egaldem | 0.0258 | 0.0189 | 0.0303 | 0.0426 |

| alpha_Q | Rule of Law → Institutional Trust | v2x_rule | 0.0585 | 0.0596 | 0.0488 | 0.0199 |

| alpha_W | Civil Society Participation → Value Cohesion | v2x_cspart | 0.0791 | 0.0786 | 0.0618 | 0.0536 |

| alpha_Z | Deliberative Democracy → Future Orientation | v2x_delibdem | 0.0670 | 0.0715 | 0.0502 | 0.0408 |

| beta_E | Corruption → Economic Crisis | v2x_corr | 0.0249 | 0.0210 | 0.0476 | 0.0808 |

| beta_M | Alternative Information → Media Polarization (inverted) | v2xme_altinf | 0.0271 | 0.0221 | 0.0347 | 0.0399 |

| beta_P | Campaign Polarization → Polarization Force | v2cacamps | 0.0502 | –0.1493 | 0.1105 | 0.0080 |

| beta_V | Rule of Law → Mistrust (inverted) | v2x_rule | 0.0222 | 0.0205 | 0.0363 | 0.0783 |

| k_f_C | Political Exclusion → Conspiracy Thinking | v2xpe_exlpol | –0.0092 | –0.0094 | –0.0046 | –0.0030 |

| k_f_Ep | Equality before Law → Empathy | v2xcl_rol | 0.0186 | 0.0198 | 0.0180 | 0.0107 |

| k_f_ID | Deliberative Democracy → Integral Thinking | v2x_delibdem | 0.0235 | 0.0258 | 0.0151 | 0.0104 |

| k_f_MG | Corruption → Power Hunger | v2x_corr | –0.0169 | –0.0194 | –0.0027 | 0.0180 |

| k_f_R | Campaign Polarization → Revenge | v2cacamps | –0.0033 | –0.0698 | 0.0168 | –0.0173 |

| k_f_T | Freedom of Expression → Transparency | v2x_freexp | 0.0188 | 0.0192 | 0.0147 | 0.0090 |

| k_f_Wm | Political Exclusion → Science Denial | v2xpe_exlpol | –0.0192 | –0.0194 | –0.0146 | –0.0130 |

| k_f_Wp | Freedom of Expression → Science Affinity | v2x_freexp | 0.0188 | 0.0192 | 0.0147 | 0.0090 |

Auf der Basis dieser kalibrierten Parameter können wir auch in die Zukunft schauen und das Modell nutzen, um eine Zukunftsprognose zur Demokratie-Autokratie Entwicklung der jeweiligen Länder zu wagen. Man beachte, dass diese Prognose keine unerwarteten zukünftigen Ereignisse berücksichtigt, sondern lediglich eine vergangene Entwicklung in die Zukunft fortsetzt.

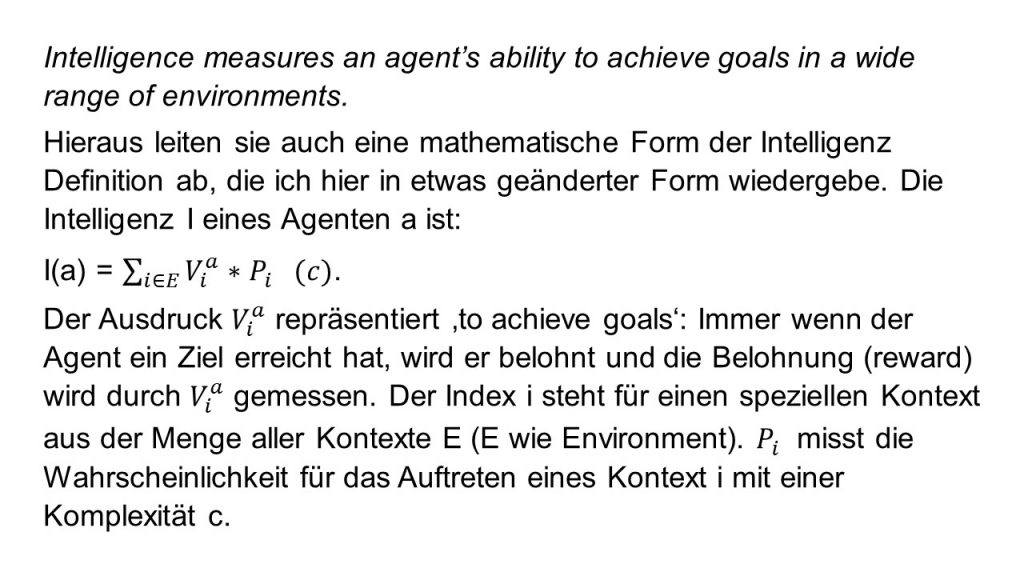

Für die Prognose benutze ich die sogenannte Sobol-Sensitivitätsanalyse [2]. Basierend auf den Ausgangsdaten für den Zeitraum 1990-2024 simuliert diese Analyse für einen Zeitraum von 50 Jahre welche Parameter zukünftig am wichtigsten sind. Mit der Sobol-Analyse ermittele ich die Parameter, die den größten Einfluss auf drei Ergebnistypen haben:

- D_final = Demokratie-Wert am Ende des Zeithorizonts von 50 Jahren

- D_change = Differenz zwischen End- und Anfangswert

- Resilienz = Durchschnittlicher Demokratie-Wert während der schlechtesten 25% der Zeit (misst die Fähigkeit des Systems, unter Druck zu bestehen).

Gemessen werden die sogenannten ST-Werte (Sensitivity Total Werte). Hohe ST-Werte (nahe 1.0) sind für einen großen Teil der Ergebnisvarianz verantwortlich. Das heißt, kleine Änderungen in diesen Parametern führen zu großen Änderungen im Ergebnis. Diese Parameter sind kritisch für das Systemverhalten. Niedrige ST-Werte (nahe 0) haben wenig Einfluss auf das Ergebnis. Diese Parameter können in weiteren Analysen oft fixiert werden. Der politische Nutzen ist offensichtlich: Die Parameter mit hohen ST-Werten sind Hebel für die demokratische Stabilisierung und Risikofrüherkennung. Z.B. bei hoher Sensitivität von `alpha_Q` (Institutionenvertrauen) sind Justizreformen besonders wirksam. Oder z.B. hoher ST-Wert für ‚lambda‘ für Deutschland zeigt an, dass für Deutschland der autokratische Feldanteil durchaus das Potential hat, Deutschland in ein autoritäres System zu kippen. Die Sobol-Analyse liefert eine wissenschaftliche Grundlage für gezielte Reformen und Risikomanagement.

Nun zu den Ergebnissen:

Abbildung 1: Für die USA wird ausgesagt, dass in allen drei Sensitivitätsanalysen jeweils 10 Parameter mit gleicher Stärke für die Demokratie von Bedeutung sind: Rosa eingefärbte Indizes zeigen Parameter des Sozialen Feldes, der blau eingefärbte Parameter steht für die Persönlichkeitseigenschaft ‚Integrales Denken‘ des demokratischen Agenten (dieser Parameter wird besonders hervorgehoben, da er in Anlehnung an das Kultur- und Bewusstseinsmodell Spiral Dynamics eine übergeordnete Bedeutung hat). Die lila eingefärbten Parameter kennzeichnen die übrigen Persönlichkeitsmerkmale der Agenten. Die rot eingefärbten Balken kennzeichnen die Stress-Faktoren des ‚Sozialen Feldes‘, hier Vertrauensverlust, wirtschaftliche Probleme und mediale Polarisierung. Die Anordnung der Parameter von links nach rechts resultiert aus minimalen numerischen Unterschieden. Alle Persönlichkeitsmerkmale des demokratischen Agenten sind von Bedeutung: Das Integrale Denken (k_f_ID), die Empathie (K_f_Ep), die Transparenz (k_f_T) und die Wissenschaftsneigung (k_f_Wp). Das Gleiche gilt für den autokratischen Agenten: Die Wissenschaftsabneigung (k_f_Wm), die Neigung zu Mystik und Verschwörungstheorien (k_f_C), die Macht- und Geldgier (k_f_MG) und die Rache (k_f_R). Die Prägung von US-Demokratie bzw. Autokratie durch Agenten ist also sehr groß!

Abbildung 2: : Für die Ukraine wird ausgesagt, dass für die drei Sensitivitätsanalysen unterschiedliche Parameter mit unterschiedlicher Stärke für die Demokratie von Bedeutung sind: Rosa eingefärbte Balken zeigen Parameter des Sozialen Feldes, der blau eingefärbte Balken steht für die Persönlichkeitseigenschaft ‚Integrales Denken‘ des demokratischen Agenten, die lila eingefärbten Balken kennzeichnen die übrigen Persönlichkeitsmerkmale der Agenten. Die grün eingefärbten Parameter kennzeichnen die demokratischen Faktoren des ‚Sozialen Feldes‘, die rot eingefärbten Parameter kennzeichnen die Stress-Faktoren des ‚Sozialen Feldes‘. Die Anordnung der Parameter von links nach rechts resultiert aus minimalen numerischen Unterschieden. Das Integrale Denken ist für alle Prognosen von Bedeutung. Die Wissenschaftsabneigung (k_f_Wm) und die Transparenz (k_f_T) spielen für den finalen Demokratiewert eine große Rolle. Wirtschaftliche Probleme (beta_E) spielen in allen Analysen eine große Rolle. Der Vertrauensverlust ist besonders wichtig für D_final und resilience. Die autokratischen und sogar rechts-libertären Agenten Eigenschaften zeigen sich in allen drei Analysen. Die Prägung der Politik durch diese Agenten ist relativ groß.

Abbildung 3: Deutschland ist das einzige der vier untersuchten Länder, bei dem der Kontrollparameter lam = lambda eine herausragende Rolle spielt. Weitere rosa eingefärbte Balken zeigen Parameter des Sozialen Feldes. Der blau eingefärbte Balken steht für die Persönlichkeitseigenschaft ‚Integrales Denken‘ des demokratischen Agenten, die lila eingefärbten Balken kennzeichnen die übrigen Persönlichkeitsmerkmale der Agenten. Die grün eingefärbten Parameter kennzeichnen die demokratischen Faktoren des ‚Sozialen Feldes‘, die rot eingefärbten Parameter kennzeichnen die Stress-Faktoren des ‚Sozialen Feldes‘. Die Anordnung der Parameter von links nach rechts resultiert aus minimalen numerischen Unterschieden. Die Persönlichkeitseigenschaften des demokratischen Agenten spielt eine große Rolle: Wissenschaftsneigung (k_f_Wp), Transparenz (k_f_T), Empathie (k_f_Ep) und Integrales Denken (k_f_ID). Für die Resilienz spielen die WerteKohäsion (alpha_W), funktionierende demokratische Institutionen (alpha_Q) und eine geringe Ungleichheit (alpha_I) eine herausragende Rolle. Diese Analysen zeigen, dass lediglich die Eigenschaften der demokratischen Agenten mitbestimmend sind, autokratische und rechts-libertäre Agenten spielen keine Rolle.

Für Ungarn konnte leider keine valide Sobol-Analyse durchgeführt werden. Lediglich ca. 17 % der ODE-Berechnungen konnten mit dem vorliegenden Parametersatz erfolgreich abgeschlossen werden. – Deshalb sind alle Prognosen nicht valide. – Es ist möglich, dass dies an Instabilitäten der Rechnungen liegt, jedoch zeigen diese an, dass Ungarn bis 2040 in eine chaotische Autokratie driftet. – Nicht sehr beruhigend…

Dieser Blog-Beitrag schließt (vorläufig) diese Blog-Reihe. Ich fasse meine Erkenntnisse zusammen.

Das mit KI entwickelte ODE-Modell hat sich erstaunlich gut bewährt:

- Die von V-Dem bereitgestellten Muster zum zeitlichen Übergang Demokratie-Autokratie konnten nachgebildet werden.

- Das ‚Soziale Feld‘ bestehend aus demokratischen und autokratischen Elementen hat als Ordnungsparameter die Differenz von Autokratie- und Demokratiefaktoren. Diese Differenz bildet einen Phasenübergang 1. Ordnung aus, wenn der Kontrollparameter ‚lambda‘ (sozialer Stress) einen bestimmten Wert überschreitet. Ordnungs- und Kontrollparameter bleiben bei Einführung der Agenten strukturell bestehen.

- Autokratische, demokratische und rechts-libertäre Agenten modulieren das ‚Soziale Feld‘ auf zwei Arten: Durch Veränderung des Kontrollparameters und durch unmittelbare Veränderung des Feldes durch die jeweiligen Persönlichkeitseigenschaften. Die beobachten Veränderungen des Übergangs Demokratie-Autokratie stehen u.a. im Einklang mit den aktuellen Beobachtungen für die USA.

- Die Validierung des Modells mit allgemein akzeptierten Daten des V-Dem zeigt eine erstaunliche Übereinstimmung. Auf der Basis der ODE’s mit den kalibrierten Modell-Parametern lassen sich Länder-Prognosen für die Entwicklung der Demokratie bzw. Autokratie erstellen. Diese Prognosen treffen Aussagen darüber, welche Modell-Parameter bei welchem Land von Bedeutung sind. Die Modell-Parameter für das ‚Soziale Feld‘, die Agenten Parameter sowie der Kontrollparameter haben für unterschiedliche Länder eine unterschiedliche Bedeutung: So zeigt zum Beispiel die Analyse, dass im US-amerikanischen Kontext die autokratischen Agenten ein große Rolle spielen, für Deutschland spielen diese jedoch überhaupt keine Rolle. Es überwiegt das ‚Soziale Feld‘ und die demokratischen Agenten. Die Dominanz des ‚Soziale Feld‘ für Deutschland zeigt sich auch an der Bedeutung des Kontrollparameters ‚lambda‘. Hier liegt aber auch ein besonderes Risiko: Deutschland kann in eine Autokratie kippen, ohne dass autokratische oder rechts-libertäre Agenten dies forcieren.

Auch wenn Modelle nur Modelle sind, so sind diese Ergebnis sehr bemerkenswert, da an keiner Stelle diese Ergebnisse verdeckt in die ODE‘s einfließen. Die Ergebnisse sind so länderspezifisch, dass sie als Basis zum Nachdenken anregen sollten…

Bei meinen Recherchen bin ich auf einige wissenschaftliche Artikel gestoßen, für die angegeben wird, dass sie sich dem Übergang Demokratie-Autokratie widmen. Meine nachfolgende Analyse hat ergeben, dass aus meiner Sicht nur die V-Dem Veröffentlichungen relevante Aussagen zum Übergang Demokratie-Autokratie enthalten. Eine Veröffentlichung [3] beschäftigt sich mit dem Zusammenhang von Demokratie und Human Development Index (HDI) und verwendet hierfür eine ähnliche Vorgehensweise, wie ich sie in den Blog-Artikeln verwendet habe.

Diese letzte Erkenntnis ist um so bedauerlicher, als meines Erachtens der Übergang Demokratie-Autokratie eines der wichtigsten politikwissenschaftlichen Themen unserer Zeit sein sollte.

[1] V-Dem (2025) https://www.v-dem.net/data/the-v-dem-dataset/, Datensatz: Country-Year: V-Dem Full+Others

[2] Wikipedia (2025) Variance-based sensitivity analysis, https://en.wikipedia.org/wiki/Variance-based_sensitivity_analysis

[3] Spaiser V, Ranganathan S, Mann RP, Sumpter DJT (2014) The Dynamics of Democracy, Development and Cultural Values. PLoS ONE 9(6): e97856. doi:10.1371/journal.pone.0097856